Saben si estamos tristes. Si nos preocupa algo. Si estamos en paz. Pero a las inteligencias artificiales les cuesta identificar las emociones alegres a través de nuestra voz. Un equipo de la National Research University de Moscú y sus ordenadores han enseñado a una red neuronal artificial a inferir estados de ánimo a través de las voces de personas. Lograron un 70% de éxito en tonos neutros o tristes, pero no así en los alegres, según acaban de presentar el el congreso Neuroinformatics 2017.

Las emociones son una de las tradicionales barreras donde ha chocado la inteligencia artificial a la hora de simular el cerebro. "La empatía, el humor, las sensaciones de cariño eran de las pocas áreas seguras para los humanos", apunta a El Independiente el investigador Manuel Cebrián, del MIT Media Lab. "Nosotros en el laboratorio hemos estudiado el impacto de la automatización en varias tareas y sí que parece que el terreno de las emociones, en las profesiones que tienen que ver con la gente, son menos automatizables".

Sin embargo, a día de hoy, algunos científicos sostienen que los ordenadores cuentan con una inteligencia emocional similar a la de un bebé de unos dos años de edad. Para Cebrián, "las distinciones entre habilidad manual y afectiva es un poco arbitraria, pues todo viene del cerebro. Sí que tratamos de atisbar qué cosas que se consideran supercreativas y resulta que las máquinas las pueden hacer en el sentido más básico".

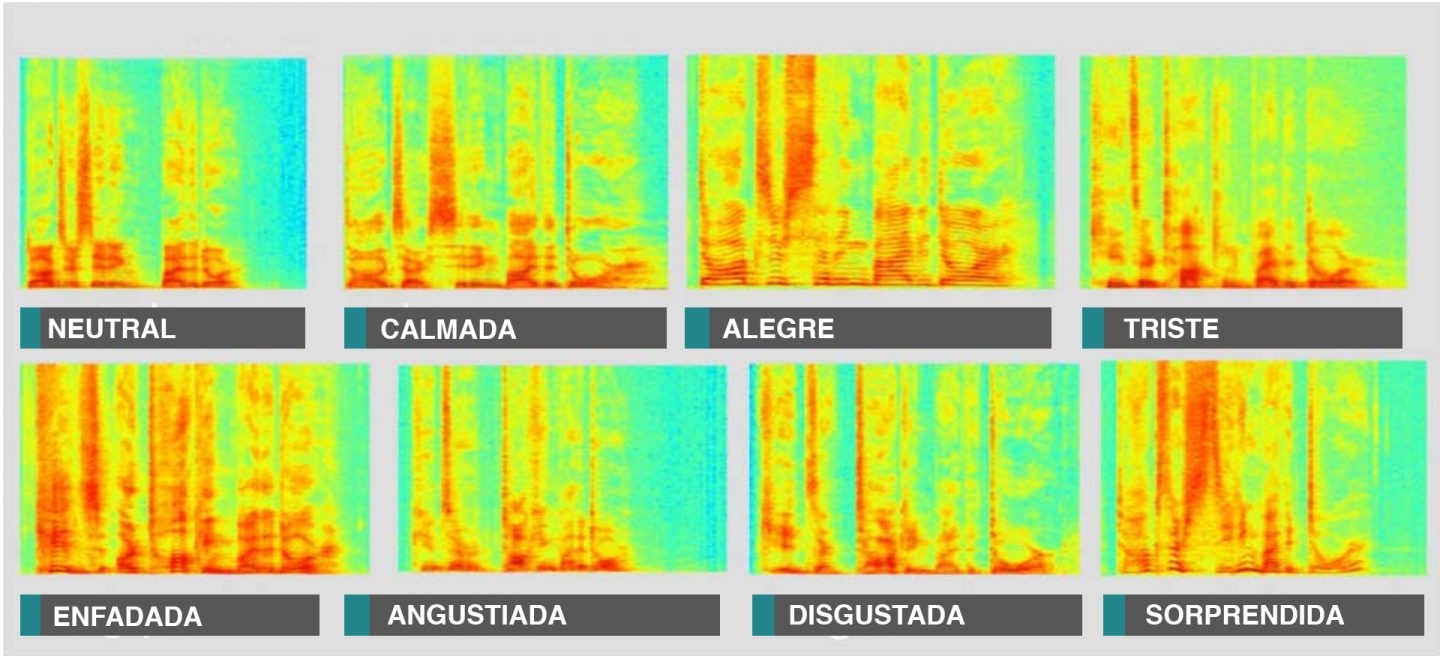

El equipo ruso, liderado por la doctora Anastasia Popova, de la Higher School of Economics, transformaron los sonidos humanos en imágenes, espectros de frecuencias. Éstos les fueron mostrados a las máquinas. Fueron poco a poco aprendiendo qué patrones se repiten en los tonos más tristes o neutrales y más alegres. El objetivo era observar si, ante una afirmación textual como "estoy bien", el interlocutor, en realidad, quiere decir lo contrario, de la misma manera que el tono en que respondemos ante un "¿cómo estás?" marca la verdadera respuesta, por encima de la literalidad de la palabra "bien".

Empatía, clave para los asistentes personales

Joaquin Phoenix se enamora de la voz de una inteligencia artificial en la película Her

Siri, Cortana, Alexa... la batalla entre los asistentes personales se libra en el terreno de la empatía. Así lo cree la profesora del MIT Media LabRosalind Picard. Añadir la detección de emociones a la electrónica personal podría mejorarla sustancialmente, según señalaba la autora de Affective Computing a la revista MIT Technology Review.

Según esta revista, los investigadores de Amazon trabajan en desarrollo del altavoz inteligente Echo, encaminado a mejorar las relaciones entre usuarios y la inteligencia artificial del gigante estadounidense.

Los investigadores están explorando nuevas técnicas de procesamiento del lenguaje natural, pero también vías para detectar la emoción de la voz del usuario.

Te puede interesar

Lo más visto

- 1 Lobato se enfrenta en el Supremo a la revelación de secretos

- 2 Lobato: morir matando. Por Casimiro García-Abadillo

- 3 Lobato, otro soplón u otro triste

- 4 La valentía de Posteguillo

- 5 Esto es lo que ocurre si se aplica Aloe Vera en la cara a diario

- 6 EEUU celebra Acción de Gracias comiendo 46 millones de pavos

- 7 EEl PP de Madrid sospecha que se creó un grupo de Whatsapp contra Ayuso

- 8 Europa se plantea enviar tropas a Ucrania

- 9 Silvia Intxaurrondo pasa al ataque contra Pablo Motos