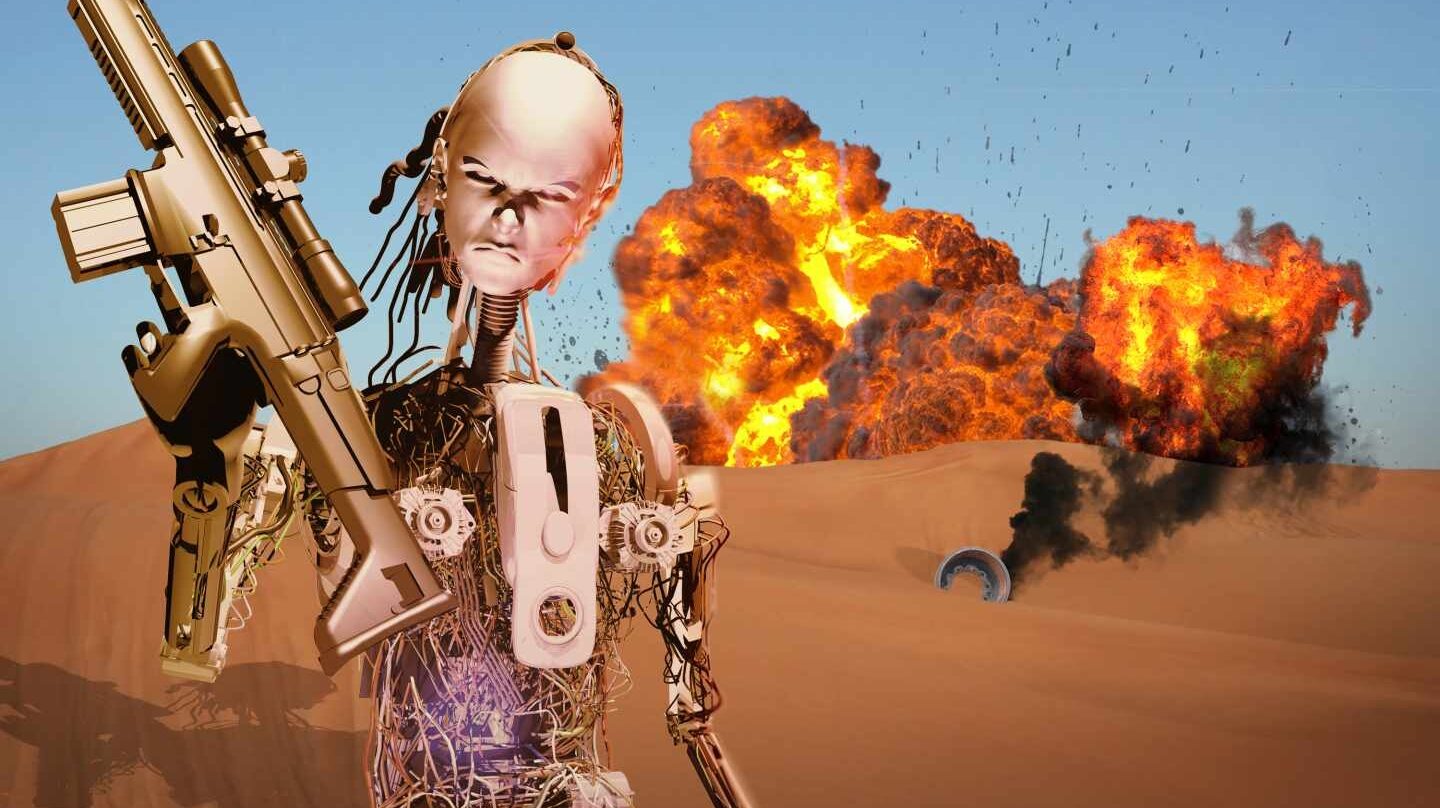

No distinguen entre amigo y enemigo, pero apuntan, disparan y matan sin la supervisión de nadie. Son máquinas –humanoides, drones o carros de combate– que deciden de manera autónoma cuál es el objetivo a abatir. Esta tercera revolución armamentística, tras las armas de fuego y las nucleares, podría tomar los campos de batalla en un futuro cercano. Si caen en manos de terroristas someterían al mundo. Los expertos más destacados en inteligencia artificial están batallando por prohibir el uso de estos soldados robóticos con carta blanca para matar.

A finales de otoño el cortometraje ‘Slaughterbots’ se hizo viral. Muestra un porvenir distópico donde los robots automatizados para matar están a la orden del día. Enjambres de drones, minúsculos como insectos, podrían acceder al interior de cualquier recinto, identificarían a sus víctimas mediante una herramienta de reconocimiento facial e impactarían contra su cráneo hasta hacer estallar su cerebro.

“El vídeo es más que una especulación. Muestra el resultado de integrar y miniaturizar tecnologías de las que ya disponemos hoy en día”, asegura el autor, Stuart Russell, experto en Inteligencia Artificial en la Universidad California Berkeley. “Permitir a las máquinas elegir matar humanos será devastador para nuestra seguridad y libertad”, advierte este profesor de ciencias de la computación. Los ataques del ejército podrían llegar a ser de precisión quirúrgica para evitar muertes colaterales. Pero también un grupo violento extremista podría programar estos robots para, por ejemplo, ejecutar a aquellos que estén difundiendo en sus redes sociales información que les perjudique.

No son pocos los ejércitos que están trabajando en el desarrollo de armas autónomas. "Delegar en una máquina el acto de matar es indigno”, asegura a El Independiente Ramón López de Mantarás, director del Instituto de Investigación en Inteligencia Artificial (IIIA). “Estas máquinas no pueden distinguir la actitud de rendición ni tienen compasión”, ilustra el investigador del CSIC. Ha firmado junto a miles de científicos, expertos en inteligencia artificial y robótica, una carta abierta pidiendo la prohibición de los robots con autonomía para matar.

“Es cuestión de tiempo que lleguen al mercado negro, caigan en manos de terroristas, de algún dictador que desea controlar más a la población o un jefe militar que quiera matar a una etnia en particular”, reflexionan en la carta, redactada por el Instituto para el Futuro de la Vida, del que forman parte personalidades como el visionario empresario Elon Musk o el físico Stephen Hawking. “A diferencia de las armas nucleares, estos robots no requieren materias primas caras, son baratos y terminarían fabricándose en masa”, explican.

A diferencia de las armas nucleares, estos robots son baratos y terminarían fabricándose en masa

Una de las armas autónomas más usadas actualmente es Super aEgis II. Tiene el aspecto de una gran ametralladora fija. La máquina tiene capacidad detectar, perseguir con la mirilla y disparar sin que un humano tenga que intervenir. Se usa actualmente en varias localizaciones de Oriente Medio.

El diseño original no contaba con la opción de bloquear el arma con una contraseña. Fue incluida a petición de los consumidores porque la máquina no puede distinguir entre amigo y enemigo. Esta tarea debe realizarla un humano, un inconveniente que trabajan actualmente en solventar sus diseñadores. Su deseo es que el robot pueda ser independiente, capaz de decidir. “La simbiosis hombre máquina no se debería romper nunca. Hay que seguir trabajando en equipo y evitar la autonomía de los robots”, se lamenta Mantarás.

Los robots actuales toman decisiones dirigidas a cumplir su objetivo. Llevan a cabo de manera sensacional tareas concretas, pero son poco flexibles. “Hay robots que juegan al ajedrez mucho mejor que los humanos, pero no tan bien a las damas, aunque sea un juego parecido”, ilustra el experto. La inteligencia artificial todavía no puede computar satisfactoriamente conceptos ambiguos o abstractos.

“Aún no tenemos ni idea de cómo incorporar elementos éticos en las decisiones que toma un robot. No sabemos cómo hacer que los valores de una máquina estén alineados con los de los humanos”, continúa López de Mantarás. Un robot algorítmico no puede cuestionarse su finalidad. Si lo hiciera ya no sería una máquina, sino un ser vivo pensante. Se podría intentar pre programar todas las rutas de toma de decisiones, pero es demasiado complejo definir con algoritmos el sentido de la justicia o el daño. Los más optimistas auguran que en una década los ingenieros lo lograrán. “Estoy en completo desacuerdo. Es impensable", esclarece.

En el caso de que ese momento llegue, ¿quién asumiría la culpa si un soldado robot mata inocentes? ¿El fabricante? ¿El programador? ¿La persona encargada del mantenimiento? ¿Aquél que dio la orden de utilizar el arma?

El pasado noviembre se reunieron en Ginebra 86 países para discutir sobre la posible prohibición de las armas autónomas en el marco del Convenio sobre Ciertas Armas Convencionales (CCW), donde se discute la restricción o prohibición de armas que causan daño innecesario. La coalición de ONGs Stop Killer Robots propone desde el inicio del boom de la inteligencia artificial prohibir el desarrollo, producción y uso de armas autónomas, de igual manera que se hizo con los láseres cegadores en los años ochenta, dispositivos que servirían para dejar ciego de manera permanente al enemigo en el campo de batalla. Por el momento, 22 países apoyan la creación de una ley que prohíba estas armas. Este año volverán a reunirse y para 2019 esperan tener listo un protocolo para frenar la revolución de los soldados robot con licencia para matar.

Te puede interesar

Lo más visto

- 1 El manicomio tertuliano en la muerte del Papa

- 2 El papa rojo y los ateos creyentes

- 3 Estos son los posibles sucesores del Papa Francisco

- 4 Sánchez anuncia que España alcanzará el 2% de gasto militar en 2025 con un plan de 10.471 millones extra

- 5 Alvise rompe con sus eurodiputados y sella un año trágico en SALF

- 6 Siga en directo la comparecencia de Pedro Sánchez

- 7 El 'idilio' del Gobierno con Francisco, el Papa que ayudó a exhumar a Franco y transformar Cuelgamuros

- 8 El Gobierno aprueba la nueva ayuda de 200 euros para la crianza

- 9 Marruecos: Dirigentes y bases del PSOE acusan a Albares de violar legalidad internacional